Robots.txt : qu’est-ce que c’est et à quoi ça sert ?

18-08-2023 - Maintenance

Vous souhaitez que votre site web soit facilement repérable par les utilisateurs en ligne ? Découvrez comment Aikini peut vous aider à optimiser le fichier robots.txt et le temps de crawl pour améliorer la visibilité de votre site sur les moteurs de recherche.

1. Comprendre le fichier robots.txt : la clé de la visibilité en ligne

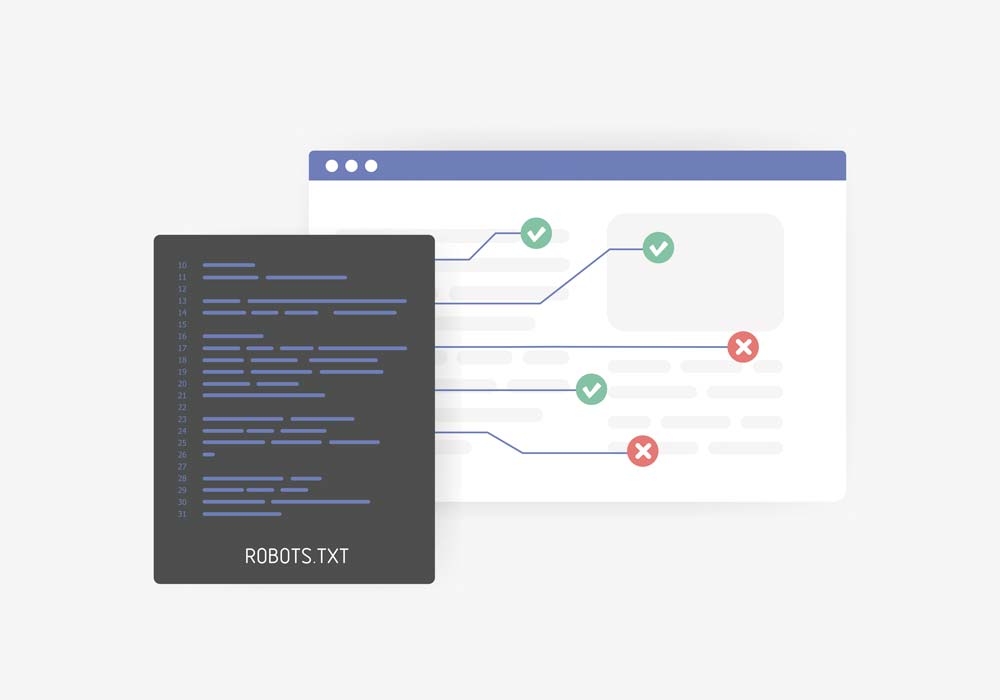

Le fichier robots.txt tient un rôle crucial dans l'optimisation de la visibilité de votre site web sur les moteurs de recherche. Il agit comme un guide pour orienter les robots de recherche vers les zones pertinentes de votre site, tel un plan qui indique les chemins à suivre.

Imaginez-le comme un assistant de voyage pour ces explorateurs numériques, les aidant à naviguer avec succès à travers votre site. Chez Aikini, nous reconnaissons l'importance de ce fichier stratégique et nous mettons à votre disposition notre expertise pour sa configuration optimale.

En travaillant ensemble, nous vous aidons à tracer un chemin clair pour les robots, garantissant qu'ils accèdent aux parties les plus pertinentes de votre site, ce qui se traduit par une exploration efficace et une visibilité accrue.

2. Temps de crawl : l'importance de l'optimisation

Le temps de crawl revêt une importance fondamentale dans le processus d'indexation de votre site web par les robots de recherche. Il désigne la durée nécessaire à ces robots pour explorer l'ensemble de vos pages et les ajouter à leur base de données.

Chez Aikini Web & Tech, nous comprenons à quel point un temps de crawl optimal est déterminant pour une visibilité accrue. C'est pourquoi nous mettons en œuvre des techniques d'optimisation spécifiques du fichier robots.txt, visant à réduire ce temps. Nous ajustons la structure de votre site de manière stratégique, rendant les parcours des robots plus fluides et directs.

En effectuant ces ajustements, nous permettons aux robots de localiser rapidement et efficacement le contenu clé de votre site, maximisant ainsi l'efficacité de l'indexation et contribuant à une meilleure visibilité sur les moteurs de recherche.

3. Techniques d'optimisation pour une visibilité maximale

Utiliser des mots clés pertinents

Lorsque les robots de recherche parcourent votre site, ils se basent sur des mots clés pour comprendre de quoi traite chaque page. Chez Aikini, nous vous accompagnons dans l'identification et l'utilisation de mots clés pertinents pour votre secteur d'activité. En choisissant les mots clés appropriés, vous garantissez que les robots comprennent instantanément la nature et le sujet de vos contenus, augmentant ainsi vos chances d'apparaître dans les résultats de recherche pertinents.

Structurer le site web de manière logique :

Imaginez votre site web comme une bibliothèque bien organisée. Nous collaborons avec vous pour structurer vos pages de manière cohérente et logique, créant ainsi un itinéraire clair pour les robots de recherche. Chaque section et chaque page de votre site sont soigneusement disposées, permettant aux robots de naviguer aisément d'une page à l'autre. Grâce à cette structure logique, nous favorisons une exploration fluide et optimale, ce qui contribue à une indexation plus complète de vos contenus.

Contrôler l'accès avec le fichier robots.txt :

Tout comme vous contrôlez qui entre chez vous, nous vous aidons à contrôler ce que les robots explorent sur votre site. À l'aide de directives spécifiques dans le fichier robots.txt, nous permettons aux robots d'accéder aux parties essentielles de votre site tout en empêchant l'accès aux zones moins importantes ou confidentielles. Cette gestion précise de l'accès garantit que les robots se concentrent sur ce qui compte le plus, améliorant ainsi la pertinence de l'indexation et la visibilité de votre contenu sur les moteurs de recherche. Chez Aikini, notre expertise vous assure que les robots explorent intelligemment votre site, en mettant en avant les informations essentielles pour les utilisateurs en ligne.

En combinant ces techniques d'optimisation, nous travaillons en collaboration avec vous pour garantir que votre site web est performant, pour une visibilité maximale. Grâce à des mots clés pertinents, une structure logique et un contrôle précis de l'accès, vous maximisez vos chances d'être découvert par les moteurs de recherche et de fournir aux utilisateurs en ligne les informations qu'ils recherchent. Afin d’évaluer les résultats de ce travail, vous pouvez utiliser des KPI de site internet pertinents.

4. Expertise de Aikini Web & Tech : Votre partenaire pour l'optimisation du robots.txt

Chez Aikini, nous comprenons que maîtriser le fichier robots.txt peut sembler complexe. Notre équipe d'experts vous accompagne à chaque étape pour garantir une exploration efficace de votre site par les robots, améliorant ainsi votre visibilité en ligne.

L'optimisation du fichier robots.txt et la gestion du temps de crawl sont des éléments clés pour améliorer votre visibilité en ligne. Chez Aikini, nous sommes là pour vous guider dans ce processus, en vous offrant l'expertise nécessaire pour optimiser ces aspects essentiels de votre présence en ligne.